Apa itu Web Archiving ?

Web Achiving atau pengarsipan adalah proses pengumpulan bagian dari World Wide Web (WWW) untuk memastikan informasi yang diawetkan dalam arsip bagi para peneliti di masa depan, sejarawan, dan masyarakat umum. Web terbesar pengarsipan organisasi berdasarkan pendekatan merangkak massal adalah Internet Archive yang berusaha untuk memelihara arsip dari seluruh Web Perpustakaan Nasional , Arsip Nasional dan berbagai konsorsium organisasi juga terlibat dalam pengarsipan konten Web budaya penting. Web komersial pengarsipan perangkat lunak tersedia untuk organisasi yang perlu arsip konten web.

Pengumpulan Web

Arsiparis web umumnya biasanya mengumpulkan arsip berbagai jenis konten web termasuk HTML halaman web, style sheet , JavaScript , gambar , dan video yang . Mereka juga arsip metadata tentang sumber daya dikumpulkan seperti waktu akses, tipe MIME , dan panjang konten. Metadata ini berguna dalam membangun keaslian dan asal dari koleksi arsip. Jangan lupa tak begitu saja arsiparis mengumpulkan arsip yang begitu banyak adanya, tentu saja ada metode-metodenya.

*maksudnya arsiparis diatas adalah orang yang mengelola, memelihara, dan memberikan informasi suatu dokumen/file. Oke silahkan simak metode dibawah ini :

Metode Pengumpulan web

1. Jauh panen

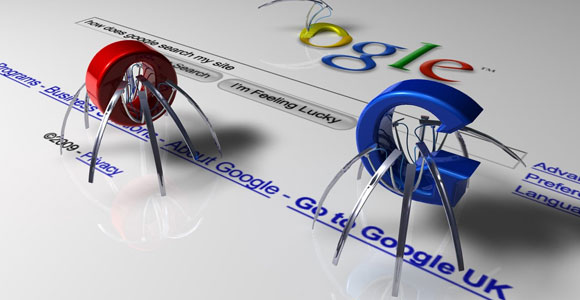

Yang paling umum teknik web pengarsipan bekerja sama dengan web crawler untuk mengotomatisasi proses pengumpulan halaman web . Web crawler biasanya mengakses halaman web dengan cara yang sama bahwa pengguna dengan browser melihat Web, dan karena itu menyediakan metode yang relatif sederhana konten web panen jauh. Contoh web crawler digunakan untuk web pengarsipan meliputi:

• Heritrix

• HTTrack

• Wget

2. On-Demand

Ada banyak layanan yang dapat digunakan untuk sumber arsip web "on-demand", namun menggunakan teknik web merangkak. Layanannya seperti berikut :

• Aleph Arsip, layanan pengarsipan web untuk kepatuhan terhadap peraturan dan eDiscovery bertujuan untuk perusahaan industri hukum dan pemerintah.

• Archive.is, sebuah layanan gratis yang menyimpan halaman dan semua gambar nya. Hal ini dapat menyimpan halaman Web 2.0.

• Arsip-It, sebuah layanan berlangganan yang memungkinkan lembaga untuk membangun, mengelola dan mencari arsip web mereka sendiri.

• Archivethe.net, shared web-platform pengarsipan dioperasikan oleh Internet Research Memory, spin-off dari memori internet dasar (sebelumnya Yayasan Arsip Eropa). IM Situs Web.

• WatchDog oleh SiteQuest Teknologi, sebuah layanan berlangganan yang memungkinkan pengguna untuk menelusuri situs, seperti yang muncul di masa lalu. Hal ini juga memonitor situs jika disitus tersebut terdapat perubahan.

• Snapshot freezePAGE, sebuah layanan gratis / berlangganan. Untuk melestarikan snapshot.

• NextPoint, menawarkan berbasis cloud otomatis, untuk kebutuhan terkait pemasaran, kepatuhan dan litigasi termasuk penemuan elektronik

• Situs-Archive.com, layanan berlangganan. Menangkap layar-tembakan halaman, transaksi dan perjalanan pengguna menggunakan "browser yang sebenarnya". Layar-tembakan dapat dilihat secara online atau download dalam arsip bulanan. Menggunakan Pengujian Cloud teknologi.

• Dll, karna penyedia layanan situs archive ini sangatlah banyak.

Database Pengarsipan

Database pengarsipan mengacu pada metode untuk pengarsipan konten yang mendasari situs database-driven. Hal ini biasanya memerlukan ekstraksi dari basis data konten ke standar skema , sering menggunakan XML . Setelah disimpan dalam format standar, konten diarsipkan beberapa database kemudian dapat dibuat tersedia menggunakan sistem akses tunggal. Pendekatan ini dicontohkan oleh DeepArc dan Xinq alat yang dikembangkan oleh Bibliotheque nationale de France dan National Library of Australia.

Transaksional Pengarsipan

Transaksional pengarsipan merupakan pendekatan-event, yang mengumpulkan transaksi aktual yang terjadi antara server web dan browser web . Hal ini terutama digunakan sebagai sarana melestarikan bukti dari isi yang sebenarnya dilihat pada tertentu situs web , pada tanggal tertentu.

Sebuah sistem pengarsipan transaksional biasanya beroperasi dengan mencegat setiap HTTP request ke, dan respon dari, web server, penyaringan setiap respon untuk menghilangkan duplikat konten, dan secara permanen menyimpan tanggapan sebagai bitstreams. Sebuah sistem pengarsipan transaksional membutuhkan instalasi perangkat lunak pada server web, dan karenanya tidak dapat digunakan untuk mengumpulkan konten dari situs remote.

Crawler

Web arsip yang mengandalkan web merangkak sebagai sarana utama mereka mengumpulkan Web dipengaruhi oleh kesulitan merangkak web :

• Para robot protokol pengecualian dapat meminta crawler tidak dapat mengakses bagian dari sebuah situs web.

• Sebagian besar dari sebuah situs web mungkin tersembunyi di dalam Web . Misalnya, halaman hasil balik formulir web terletak pada dalam Web karena kebanyakan crawler tidak bisa mengikuti link ke halaman hasil.

• Perangkap Crawler, dapat menyebabkan crawler untuk men-download jumlah tak terbatas halaman, sehingga crawler biasanya dikonfigurasi untuk membatasi jumlah halaman dinamis sehingga tidak pesat kemajuannya.

Namun, penting untuk dicatat bahwa format web arsip asli, yaitu, dibrowse arsip web sepenuhnya, dengan link kerja, media, dll, hanya benar-benar mungkin menggunakan teknologi crawler.

Keterbatasan Umum

Tidak hanya harus arsiparis web menghadapi tantangan teknis web pengarsipan, mereka juga harus berhadapan dengan hukum kekayaan intelektual. Peter Lyman menyatakan bahwa "Meskipun Web Yang Populer Dianggap Sebagai Domain Publik Sumber Daya, Itu Hak Cipta , Dengan Demikian, Arsiparis Tidak Memiliki Hak Legal Untuk Menyalin Web ". Namun perpustakaan nasional di banyak negara memiliki hak legal untuk menyalin bagian-bagian dari web di bawah perpanjangan deposito hukum .

Beberapa arsip web nirlaba swasta yang dibuat dapat diakses publik seperti WebCite , yang Internet Archive atau memori internet memungkinkan pemilik konten untuk menyembunyikan atau menghapus konten diarsipkan bahwa mereka tidak ingin publik untuk memiliki akses ke. Arsip web lainnya hanya dapat diakses dari lokasi tertentu atau memiliki penggunaan diatur. WebCite mengutip gugatan baru terhadap caching Google.

Aspek Kurasi Web (menambahkan nilai dan memilih hanya konten yang paling relevan untuk pengguna spesifik)

Web yang memiliki kurasi, seperti kurasi digital, harus memiliki seperti :

• Sertifikasi kepercayaan dan integritas isi koleksi

• Mengumpulkan aset Web diverifikasi

• Menyediakan pencarian aset Web dan pengambilan

• Kontinuitas semantik dan ontologis dan komparatif dari isi koleksi

Dengan demikian, di samping membahas metode pengumpulan Web, mereka memberikan akses, sertifikasi, dan pengorganisasian harus disertakan. Ada satu set alat populer yang membahas langkah-langkah kurasi :

Sebuah suite alat untuk Web Kurasi oleh International Internet Preservation Consortium :

• Heritrix - situs resmi - mengumpulkan aset Web

• NutchWAX - pencarian Web arsip koleksi

• Wayback (Open source Wayback Machine) pencarian koleksi arsip Web menggunakan NutchWax

• Web Kurator Alat - Seleksi dan Pengelolaan Web Collection

• dll.

51411941 Devie Eviani

53411645 Intan Octaviani

53411659 Iqbal Maulana

54411502 Mirza Fahmi A.

Kelompok Softskill :

52411111 Dimas Fachrian51411941 Devie Eviani

53411645 Intan Octaviani

53411659 Iqbal Maulana

54411502 Mirza Fahmi A.