Pengertian Web Crawler

Dalam rangka tugas softskil, kami

ditugaskan untuk mencari beberapa ulasan seperti Analisis Web, Search Engine, Web Archiving,

dan Web Crawlers . Untuk Pembahasan yang pertama ini salah satunya yang akan

kita bahas adalah Web Crawler. Mungkin kalian bertanya Tanya sebenernya Web

Crawler itu apa sih ? trus fungsinya untuk apa ?

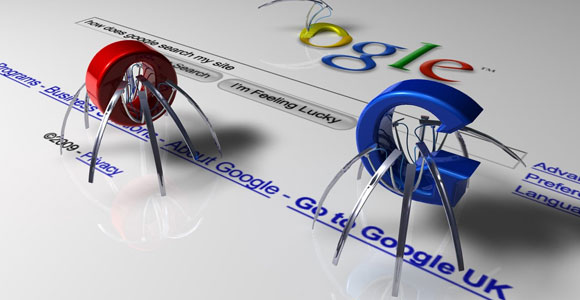

Web Crawler bisa juga disebut sebagai

bot pencarian atau spider ialah program yang berfungsi menelusuri web yang ada

di dunia maya dan berkunjung ke web-web tersebut atas nama search engine, hasil

dari spider ini untuk menemukan link baru dan halaman baru atau website baru.

Biasanya pekerjaan bot adalah mengindex dan menyimpan data di database para

pemilik botnya.

Tentu saja Web Crawler ini mempunyai

fungsi pula, nah disini Ada dua fungsi utama Web Crawler, yaitu :

Mengidentifikasikan Hyperlink.

Hyperlink yang ditemui pada konten

akan ditambahkan pada daftar visit, disebut juga dengan istilah frontier.

Melakukan proses kunjungan/visit

secara rekursif.

Dari setiap Hyperlink, web crawler

akan menjelajahinya dan melakukan proses berulang, dengan ketentuan yang

disesuaikan dengan keperluan aplikasi. Untuk gambarnya bisa dilihat dibawah :

Arsitektur Web Crawler

Cara Kerja Web Crawler

Crawler diawali dengan adanya daftar

URL yang akan dikunjungi (seeds). Setelah crawler mengunjungi URL tersebut,

kemudian mengidentifikasi semua hyperlink dari halaman itu dan menambahkan

kembali ke dalam seeds (Crawl Frontier). Setelah web crawler mengunjungi

halaman-halaman web yang ditentukan di dalam seeds, maka web crawler membawa

data-data yang dicari oleh user kemudian menyimpannya ke sebuah storage.

Web crawler dapat dibuat untuk mencari

informasi yang berhubungan dengan topic tertentu saja. Web crawler yang hanya

mengumpulkan topic tertentu saja disebut topical web crawler. Web crawler

dimulai dengan sekumpulan URL, kemudian di download setiap halamannya,

mendapatkan link dari setiap page yang dikunjungi kemudian mengulangi kembali

proses crawling pada setiap link halaman tersebut. Untuk gambar cara kerjanya

lihat dibawah :

Beberapa Contoh dari Web Crawler :

1. Teleport Pro

Salah satu software web crawler untuk

keperluan offline browsing, software ini cukup popular, terutama pada saat

koneksi internet tidak semudah dan secepat sekarang. Software ini berbayar dan

beralamatkan di http://www.tenmax.com/

2. HTTrack

Ditulis dengan menggunakan bahasa

Pemrograman C, merupakan software yang dapat mendownload konten website menjadi

sebuah mirror pada harddisk, agar dapat dilihat secara offline. Yang menarik

dari software ini free dan dapat didownload pada website resminya di

http://www.httrack.com .

3. Googlebot

Web crawler untuk membangun index

pencarian yang digunakan oleh search engine google. Bila website Anda ditemukan

oleh orang lain melalui Google, bias jadi itu dari Googlebot.

4. Yahoo! Slurp

Ini merupakan search engine Yahoo,

teknologinya dikembangkan oleh Inktomi Corporation yang diakusisi oleh Yahoo!.

5. YaCy

Berbeda dengan yang lain , YaCy dibangun

atas prinsip P2P (peer-to-peer), di develop dengan java, dan didistribusikan

pada beberapa ratus mesin komputer (YaCy peers). Tiap peer di share dengan

prinsip P2P untuk berbagi index, sehingga tidak memerlukan server central.

Contoh search engine yang menggunakan YaCy ialah Sciencenet

(http://sciencenet.fzk.de ), untuk pencarian dokumen di bidang sains.

51411941 Devie Eviani

53411645 Intan Octaviani

53411659 Iqbal Maulana

54411502 Mirza Fahmi A.

Kelompok Softskill :

52411111 Dimas Fachrian51411941 Devie Eviani

53411645 Intan Octaviani

53411659 Iqbal Maulana

54411502 Mirza Fahmi A.

No comments:

Post a Comment